Sommersemester 2018, BA/MA Produkt-Design

HUA²

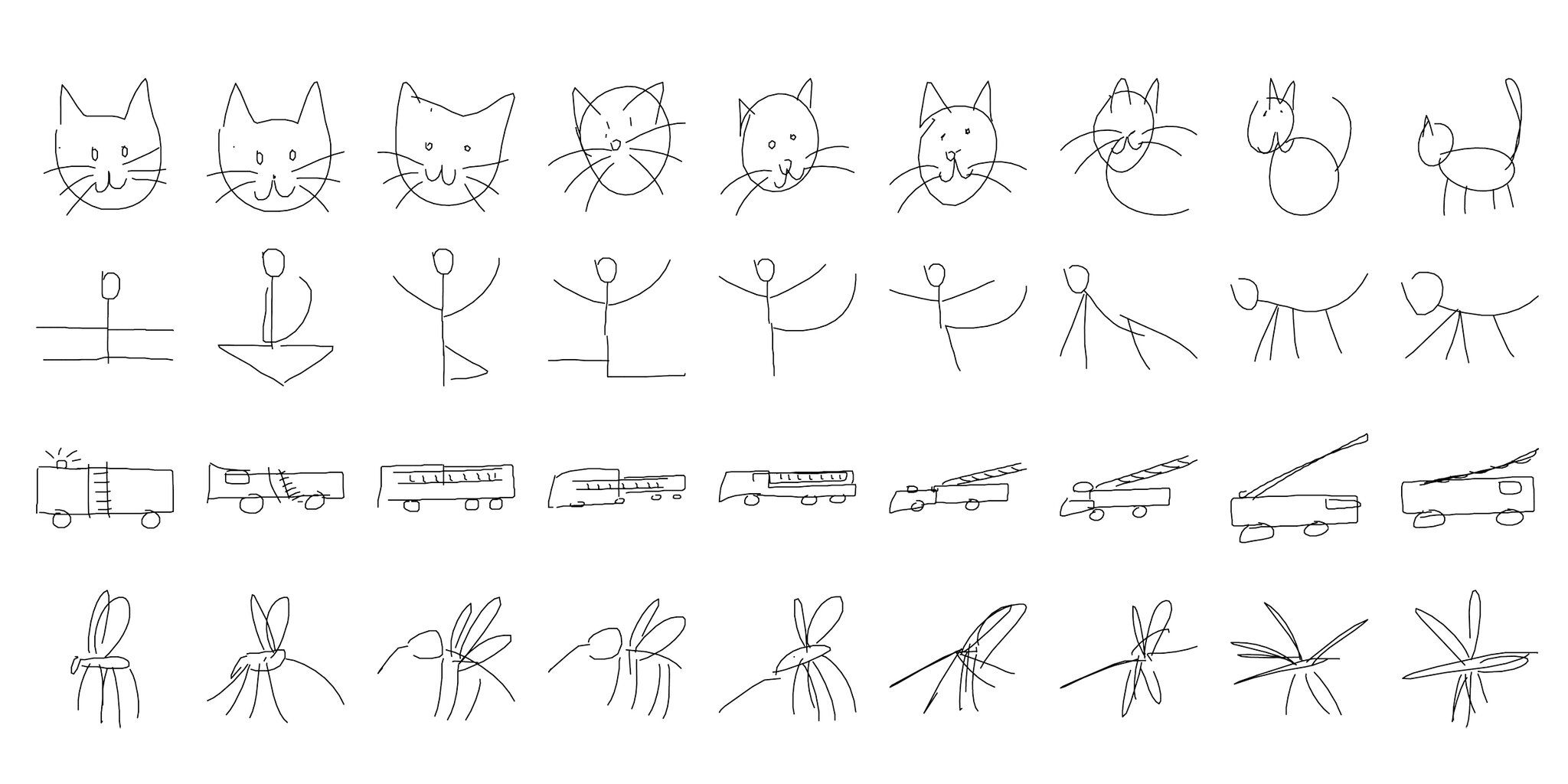

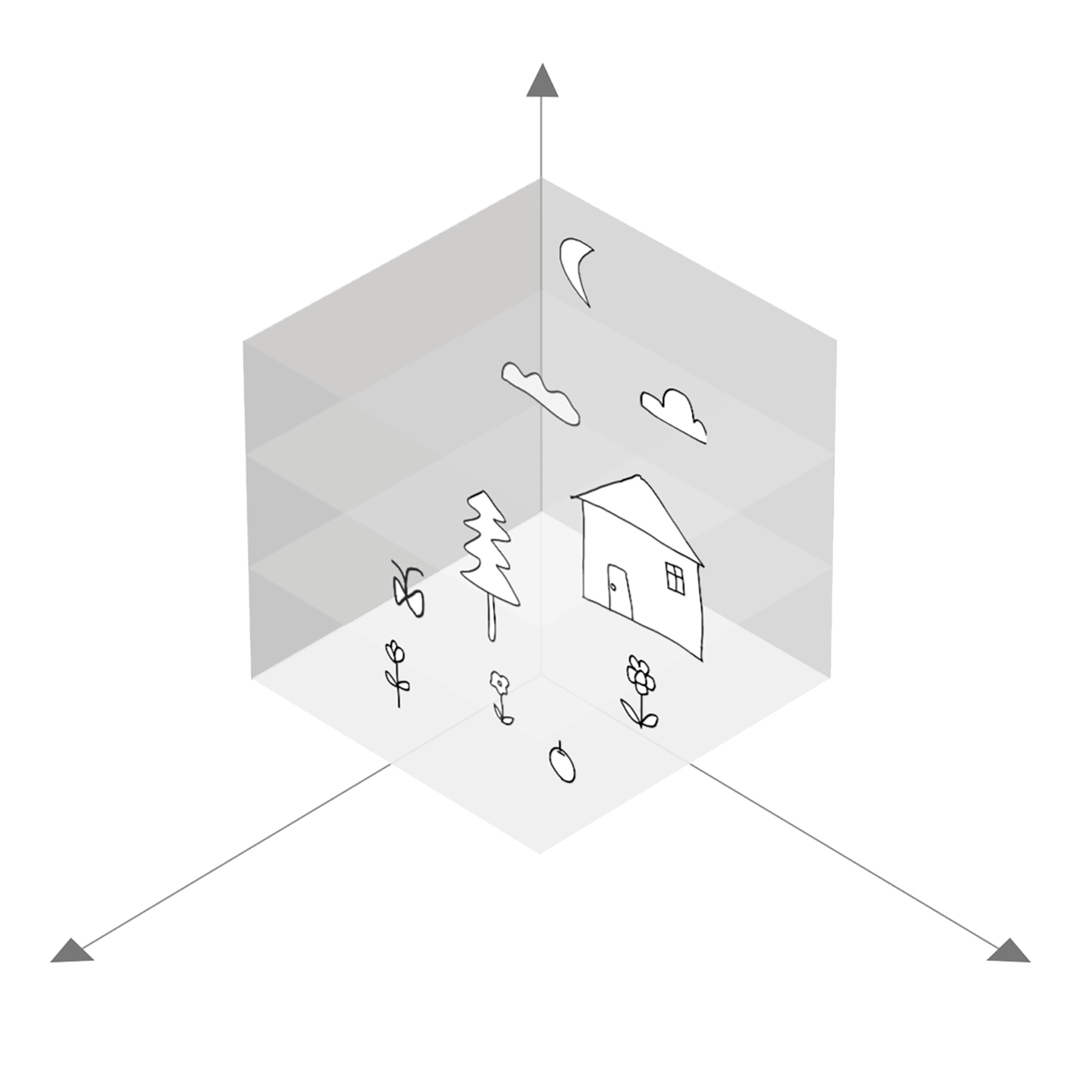

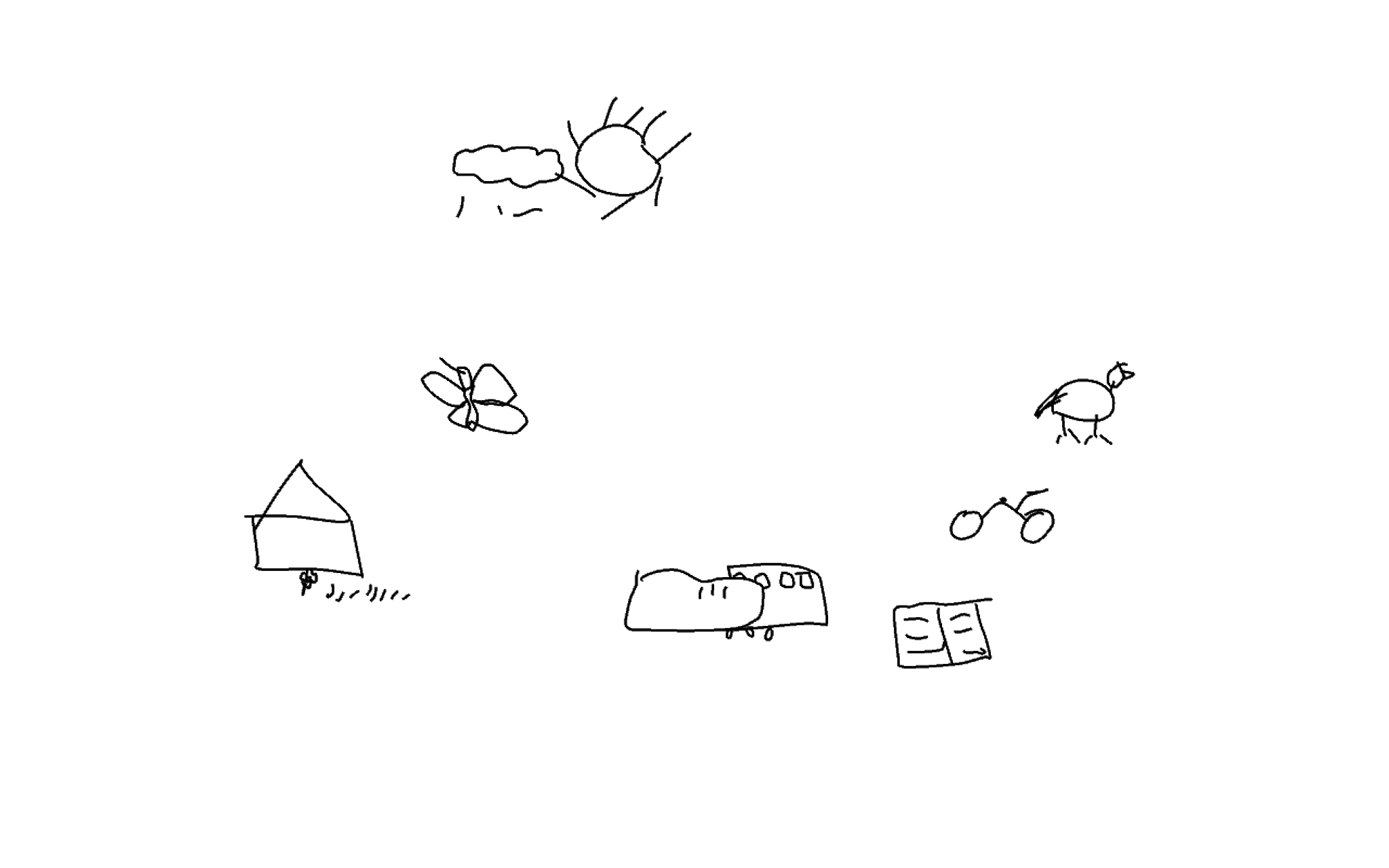

Sprache und Bilder sind eng miteinander verbunden: Wir denken in Bildern und wir erklären Sachverhalte als räumliche Konstellationen. Was wäre, wenn das gesprochene Wort in Echtzeit in dynamische Bildwelten umgewandelt werden könnte? Die Kombination von Spracheingabe, machine learning und rekurrenten neuronalen Netzwerken zur Bilderzeugung erlauben es, komplexe räumliche Bildwelten zu generieren. Sie folgen dem Sprechenden und werden so zu komplexen, durch Sprachstrukturen gesteuerten Animationen.

Language and images are closely intertwined: We think in pictures and we explain facts as spatial constellations. What if the spoken word could be transformed into dynamic visual worlds in real time? Speech input, machine learning and recurrent neural networks for image generation allow to computer generate complex imaginary worlds that follow the narrator and thus create complex animations controlled by linguistic structures.

Alle Rechte vorbehalten Xinyue Yang

Alle Rechte vorbehalten Xinyue Yang

Alle Rechte vorbehalten Xinyue Yang

Alle Rechte vorbehalten Xinyue Yang